「计算机基础」多CPU架构演进

昨天和前天通过文章《「计算机基础」CPU历史之AMD系列》和《「计算机基础」CPU历史之Intel系列》介绍了Intel和AMD的产品,今天围绕的话题仍然是CPU。

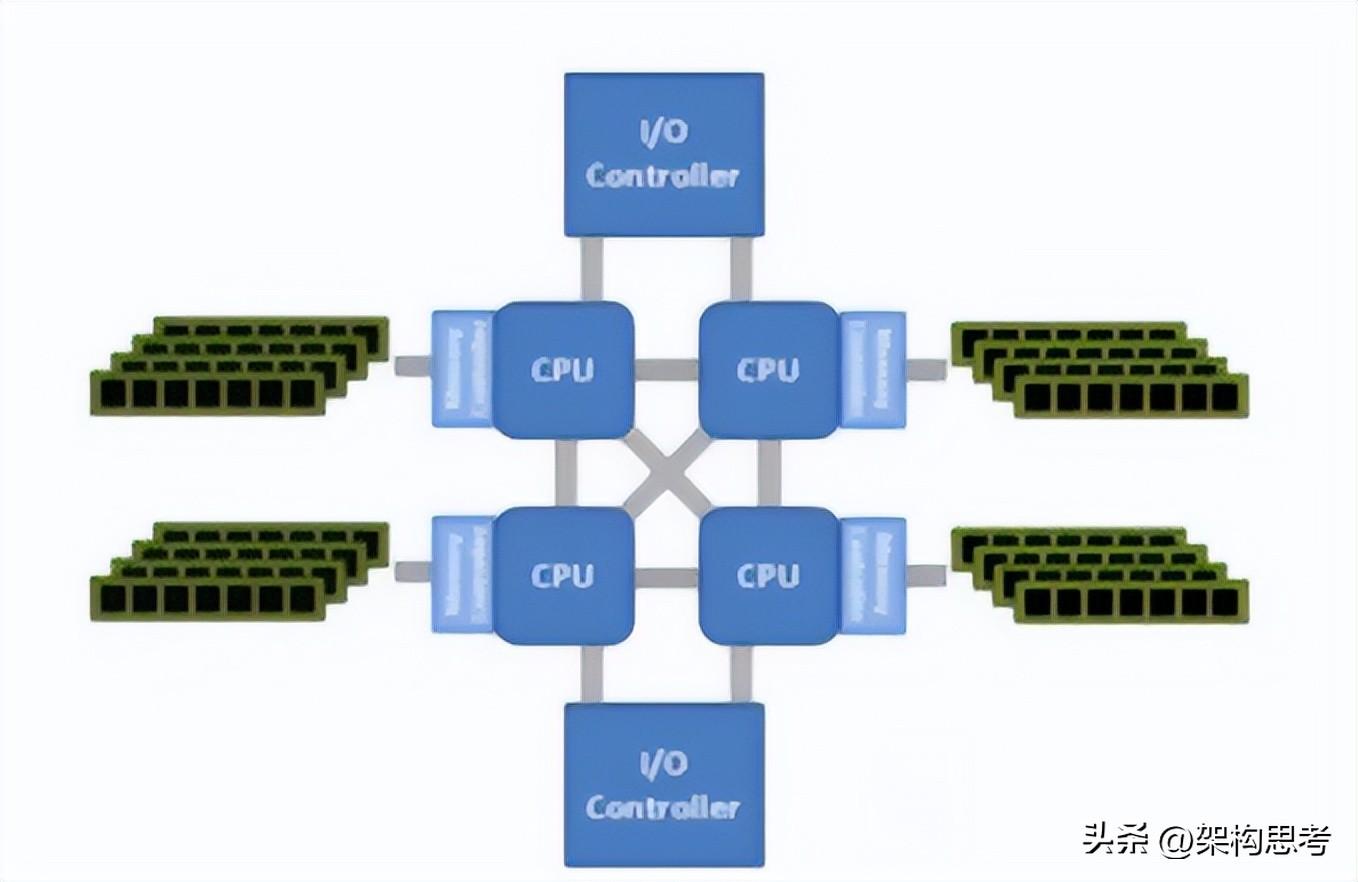

服务器最开始的时候是单CPU,然后才进化到了双CPU甚至多CPU的SMP架构。所谓SMP架构指的是多路CPU无主次,共享内存、总线、操作系统等。此时每个CPU访问内存任何地址所耗费的时间是相等的。所以也称为一致存储器访问结构

大家共享同样的内存,所以扩展能力有限,因为CPU数量增加了,内存访问冲突也会增加。为了进一步提高CPU数量的同时还能保证效率,NUMA架构出现了,将多个SMP进行松耦合。

还有一种AMP架构,不同的CPU是做不同的事的,互不干扰。

NUMA架构中,多个SMP通过Crossbar switch交换矩阵进行互联。

每个SMP有自己的内存,同时还可以访问其他SMP的内存,但是需要经过高速交换矩阵,很显然SMP访问自己的内存速度非常高,但是访问远端的SMP的内存还需要经过交换矩阵,延迟增加,可以看出NUMA通过牺牲内存的访问时延来达到更高的扩展性。

总之,SMP与NUMA架构对软件程序方面影响扩展性不大,一台主机内都使用单一的操作系统。

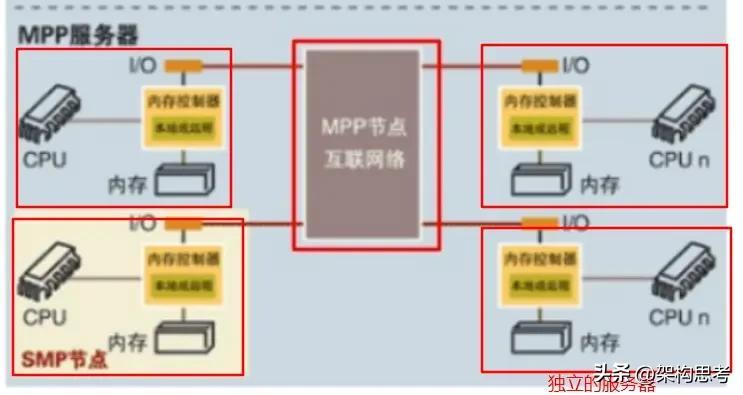

缺点是CPU数量增加,访问远端内存的时延也会增加,性能不能线性增加。此时MPP架构就出现了。

MPP说白了就是将多台独立的主机组成集群。显然在此架构下,每个节点都有各自的CPU、内存、IO总线、操作系统,完全松耦合。最关键的是MPP集群中的软件架构也相应的改变了,这样MPP的效率随节点数量增加就可以线性增加了。

其实如果NUMA架构下,如果通过上层软件来使得程序尽量少的读取远端的内存,NUMA效率也会线性增加。但是实际上NUMA操作系统仍然是同一个,内存仍然是全局均匀的,所以访问远端内存是不可避免的。

那么MPP相当于把内存强制分开,同时又改变了程序架构,这样就可以保证海量计算下的效率线性增加。

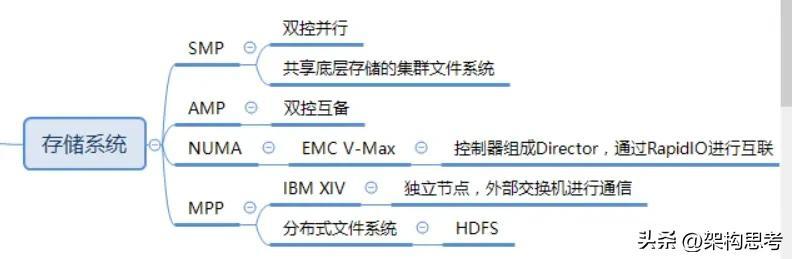

存储系统与服务器CPU架构演进相同,控制器就好比CPU,后端磁盘柜就类似于内存。

SMP

纵观存储系统的演进,一开始是单控,后来演进到双控互为备份,此时就类似于AMP,两个控制器各自处理自己的任务。

然后进入到双控并行处理的时代(HDS的AMS2000存储系统),类似于SMP,两个控制器可以并行的处理。

再到后来则有多控并行对称处理架构,Oracle的RAC集群就可以视为一种多点SMP,各种共享底层存储的集群文件系统都属于多点对称SMPNUMA

同样NUMA也出现在了存储系统中,比如EMC的V-Max相当于多个SMP利用高速交换矩阵来共享访问每个SMP上的内存,其中SMP就是一对控制器组成的Director,高速交换矩阵就是RapidIOMPP 那么IBM的XIV就属于松耦合MPP架构,每个节点都有自己的CPU、内存、IO接口,使用外部的交换机互相通信。 而HDS的VSP更像是一个紧耦合的MPP。 另一种属于MPP架构的存储系统就是分布式文件系统,比如HDFS等。

MPP对软件架构变化很大,所以传统存储厂商很难将之前的架构演进到MPP上来。

SMP/NUMA/MPP其实都算Scale-out,只不过程度和形态不同。

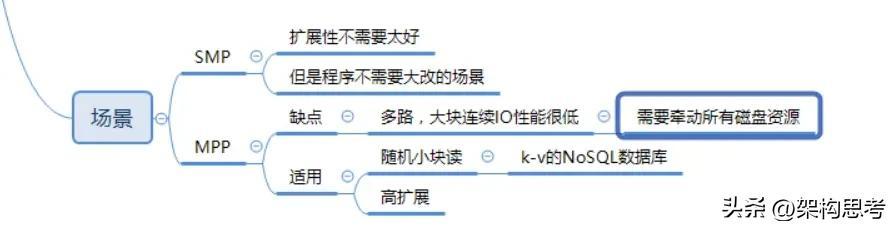

MPP架构的存储,比如XIV,在多路大块连续的IO下,效率反而很差。这是因为单路IO可能导致整个MPP集群中的磁盘资源全部牵动

但是如果是小块随机的IO,多路IO关联很少,则性能随节点数增加线性增加,这就好比将一个程序并行分解为多个子任务(类似于随机小IO),因为子任务之间的关联很少,节点之间的通信量很小,则并行执行的效率高。也就是MPP自身是share-Nothing架构,运行在上面的程序也尽可能的是Share-Nothing

SMP、NUMA、MPP各有各的好处,比如

SMP适用于扩展性要求不高,而又不想程序改变太大的场景。MPP则适用于海量数据下的高扩展性需求场景。它需要对程序进行大量的改变,而且多流大块连续IO场景下性能不佳。所以MPP架构广泛的应用于互联网的底层Key-Value分布式数据库,这种数据库主要应对高随机小块读的场景,可以获得非常高的性能。

文章来源:dy2903_https://www.cnblogs.com/dy2903/p/8341268.html

蜂蜜放了10年还能吃 尚未发酵可以食用发酵禁食

蜂蜜如果没开封的话,存放了10年其实是可以吃的。如果存放蜂蜜过久想要食用,先要判断蜂蜜有没有发酵。如果蜂蜜没有发酵,则可以拿来食用,但是如果蜂蜜发酵的话,则不建议继续食用。蜂蜜一旦开封,建议在一年之内就要食用完,超过一年可能会影响蜜蜂的功效。一、如何判断蜂蜜有没有发酵我要新鲜事2023-05-12 14:39:100000在未来的世界,机器人有没有可能产生灵智?(机器人智慧)

机器人永远不会有智慧现在其实有着非常多的人,都比较害怕看到机器人产生智慧,我们可以看到在不少的影视作品里面都有描写到关于机器人产生智慧的事情,在机器人真的有了智慧之后,对人类来说绝对不是一件好事,他们第一件事情就是先假装生存人类,然后慢慢的在反抗的力量到了能够反抗人类的时候,在人类压根没有防备的情况下,就把人类给直接碾压。我要新鲜事2023-05-15 05:23:010000研究表明:地球可能是唯一可以生存的星球,其他没有生命迹象

在这一个偌大的宇宙中,到底有多少个可以和地球一样能够拥有生命的星球呢?有许多人都会认为宇宙如此之大,而且星球也这么多,肯定会有很多像地球一样的行星,也同样会有许多高级文明。我要新鲜事2023-05-19 23:39:380000太阳不断燃烧是否对整个太阳系造成污染

在地球上,燃烧过程往往伴随着污染物的释放。燃烧化石燃料如煤、石油和天然气时,会产生大量的二氧化碳、一氧化碳、二氧化硫、氮氧化物以及各种颗粒物。这些污染物对大气、水源和土壤都有不同程度的负面影响,进而威胁到人类健康和生态系统的稳定。然而,当我们讨论太阳的“燃烧”时,情况却截然不同。我要新鲜事2024-06-17 14:14:070000阿尔卑斯山竟存在一种神秘生物,身体极似蛇且含有剧毒

在阿尔卑斯山的历史书籍上记载有一个神秘的生物——塔佐蠕虫,它的头长得跟猫非常像,但是身体上却没有毛,从整体上看,又像是一条蛇,因为它的尾巴很长,仅仅拥有两个前肢,因此它也便有了猫头蛇身的称号。我要新鲜事2023-05-14 04:43:170000